Новые технологии могут радикально повлиять на процесс создания кино. В недалеком будущем съемка фильма, возможно, обойдется без камер, декораций, локаций и даже актеров. Как бы фантастично это не казалось, подобный подход может сформироваться благодаря генеративному искусственному интеллекту. Согласно статье Variety, инструменты ИИ и лежащие в их основе модели нейросетей начинают предлагать возможности виртуального синтетического производства, способного заменить некоторые физические методы создания контента.

Генерация видеороликов по изображению или текстовому описанию, Neural Radiance Fields (NeRFs) — нейронная сеть от Nvidia, способная генерировать новые виды сложных 3D-сцен на основе двухмерных фото за несколько миллисекунд, и видео-аватары — все это входит в число новых инструментов с искусственным интеллектом, которые могут начать революцию в киноиндустрии.

Генерация видео

Инструменты генеративного видео, такие как Gen-2 и Pika от Runway, использующие Video Diffusion Models, способны создать совершенно новое видео только по текстовому описанию. Результатом являются короткие беззвучные анимации, состоящие из текста, изображений и видео.

Исследователи из Meta и Google разработали программы с аналогичными возможностями, включая Emu Video и Imagen Video. Кроме того, ожидается, что предстоящая мультимодальная программа Google Gemini предложит возможности генерации видео.

Некоторые сравнили Video Diffusion Models с кинокамерами нового типа, хотя видео в них рендерится, а не физически записывается. Возможности программ значительно улучшились за последний год и теперь позволяют получать более длинные по времени видео и более высокую четкость изображения. После недавнего обновления, Gen-2 от Runway может, вместо предыдущих четырех секунд, генерировать видео продолжительностью до 18 секунд.

На данный момент видео, полученное с помощью таких инструментов, все еще слишком несовершенно, чтобы его можно было использовать для полнометражного фильма или ТВ. Но если опустить вопросы авторского права, эти инструменты дают режиссерам большой контроль над визуальной составляющей проекта, что позволяет легче получить необходимый результат.

Ожидается, что качество и реалистичность результатов видеогенерации будет продолжать улучшаться, и это может изменить отношение к ним в индустрии в будущем.

В программные инструменты также часто добавляются новые мощные параметры управления, позволяющие пользователям более детально изменять способ рендеринга видео. Одним из примеров является режим режиссера в Gen-2, который позволяет масштабировать, регулировать скорость и поворачивать «камеру».

Neural radiance fields (NeRFs)

К NeRFs повышенное внимание проявили VFX специалисты, которые обратились к приложениям Luma AI и Nvidia Instant NeRF.

Принцип действия NeRF достаточно прост — нейронная сеть обучается на видео с любой камеры (подойдет даже ролик с iPhonе) или на наборе 2D-изображений. После этого программа объединяет данные и интерполирует их, чтобы заполнить недостающие пробелы. На выходе получается максимально реалистичная трехмерная модель объекта или сцены. Это значит, что для итогового результата не нужно показывать программе все перспективы, стороны или углы объекта.

В отличие от фотограмметрии, NeRF также сохраняет и динамически отображает все отражения, освещение и качества различных материалов (например, прозрачность стекла, блеск металла, тон человеческой кожи).

NeRF могут представлять впечатляющий потенциал для VFX специалистов и даже для режиссеров. После создания, один снимок NeRF способен отрендерить любое количество новых 3D-визуализаций, которые затем можно обрабатывать в облаке и экспортировать в различные редактируемые 3D-форматы.

Изменения могут коснуться и VFX художников, создающих реалистичные 3D-модели в Unreal Engine. Теперь NeRF способен стать значительно более простым и дешевым способом отрисовки 3D-сцен, поскольку небольшая группа фотографов может прийти к необходимому месту и снять видео или изображения для того, чтобы потом просто отрендерить это в виде NeRF.

Видео-аватары

Инструменты для создания ИИ, разработанные Synthesia, Soul Machines и HeyGen, могут сделать фотореалистичные аватары, сочетающие в себе дипфейк-видео и синтетическую речь, чтобы точно воспроизводить внешний вид, голос, выражения лица и манеры конкретного человека. Этих уникальных ИИ-аватаров называют цифровыми людьми.

Системы искусственного интеллекта создают индивидуальную модель человека, обучаясь на различных аудиовизуальных данных, независимо от того, получены ли они на профессиональных студиях или же записаны в виде обычного видеоролика дома.

ИИ-аватары могут иметь разный облик — некоторые из них гиперреалистичны и почти неотличимы от реального человека, в то время как другие по-прежнему похожи на героев видеоигр.

На данный момент, какими бы реалистичными ни казались некоторые аватары, многие из них имеют лишь ограниченный диапазон движений и выразительности лица, и в целом они производят впечатление «зловещей долины» — эмоциональной реакции, которую мы испытываем по отношению к не совсем реальным гуманоидным фигурам.

Однако, по мере развития технологий, похоже существует возможность создания полностью синтетических, гиперреалистичных аватаров, способных преодолеть эффект «зловещей долины» и выглядеть, говорить и вести себя неотличимо от реального человека.

Несмотря на это, многие, в том числе сами разработчики ИИ, полагают, что синтетические актеры вряд ли полностью заменят человеческих актеров в кино и на телевидении, по крайней мере, в главных ролях. Помимо этических последствий, понятно, что было бы чрезвычайно сложно реалистично воспроизвести полный эмоциональный диапазон и отзывчивость человека таким образом, чтобы передать волшебство актерской игры.

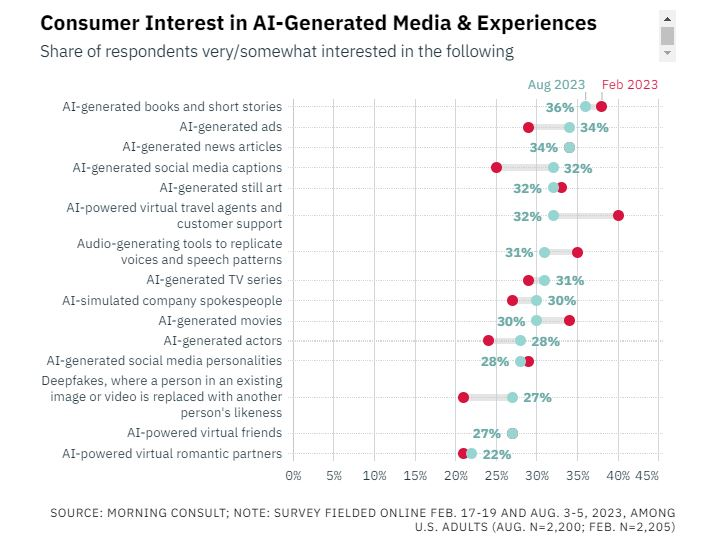

Хотя синтетические методы производства вряд ли заменят основные способы традиционного кинопроцесса в ближайшее время, вопрос о том, насколько съемки «виртуализируются» с помощью ИИ, будет зависеть от юридических или договорных аспектов, творческих принципов авторов и принятия этих нововведений зрителями.

— Источник —